性能测试之文件上传的瓶颈分析调优原创

2年前

465689

问题反馈

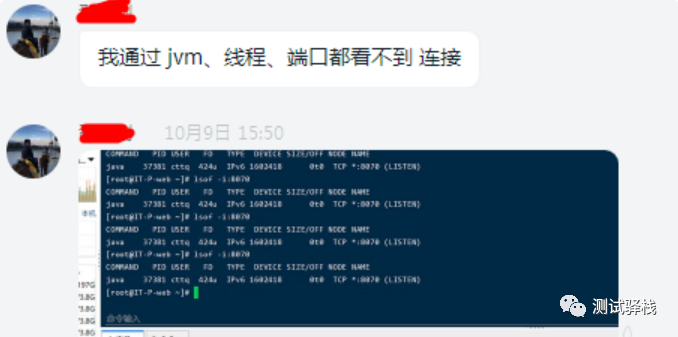

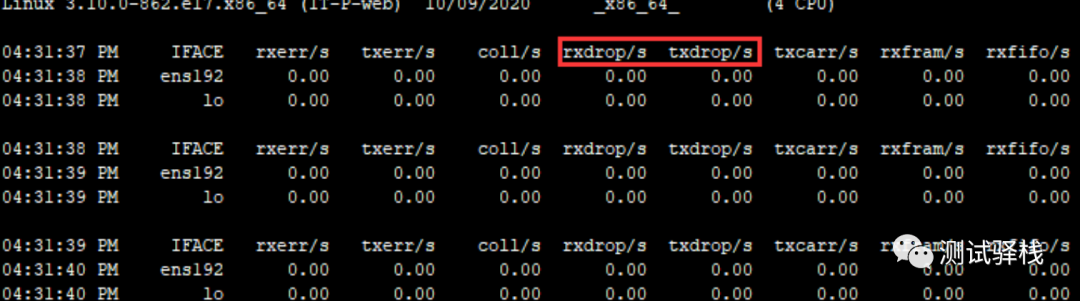

大致描述如下:并发上传 10 个文件的时候,接口完全没有响应,通过看服务器日志发现,请求根本没有到服务端,直接被某个地方拦截了。

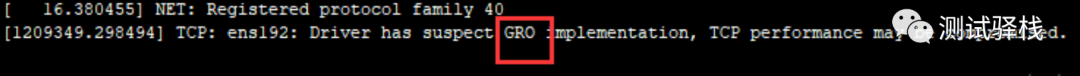

watch "dmesg | tail -20"

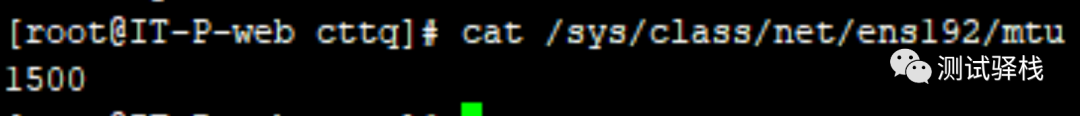

mtu

如果 I P 层有一个数据包要发送,而且数据的长度比 M T U 值还大,那么 I P 层就需要对数据进行切片,把数据包分成若干片,这样每一片都小于 M T U 值

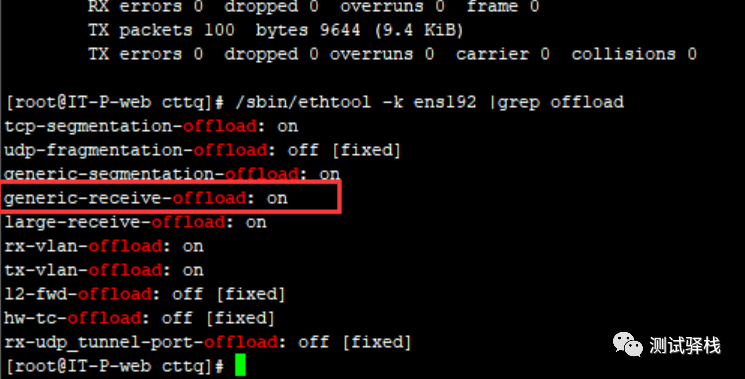

GRO

因此,如果我们用 LVS 来传输大文件的时候传输速度会极其慢。

/sbin/ethtool -k eth0 |grep offload 查看 gro 是否打开,发现果然是打开的。

mtu 默认值是 1500

结尾语

点赞收藏

分类: