4回复

3年前

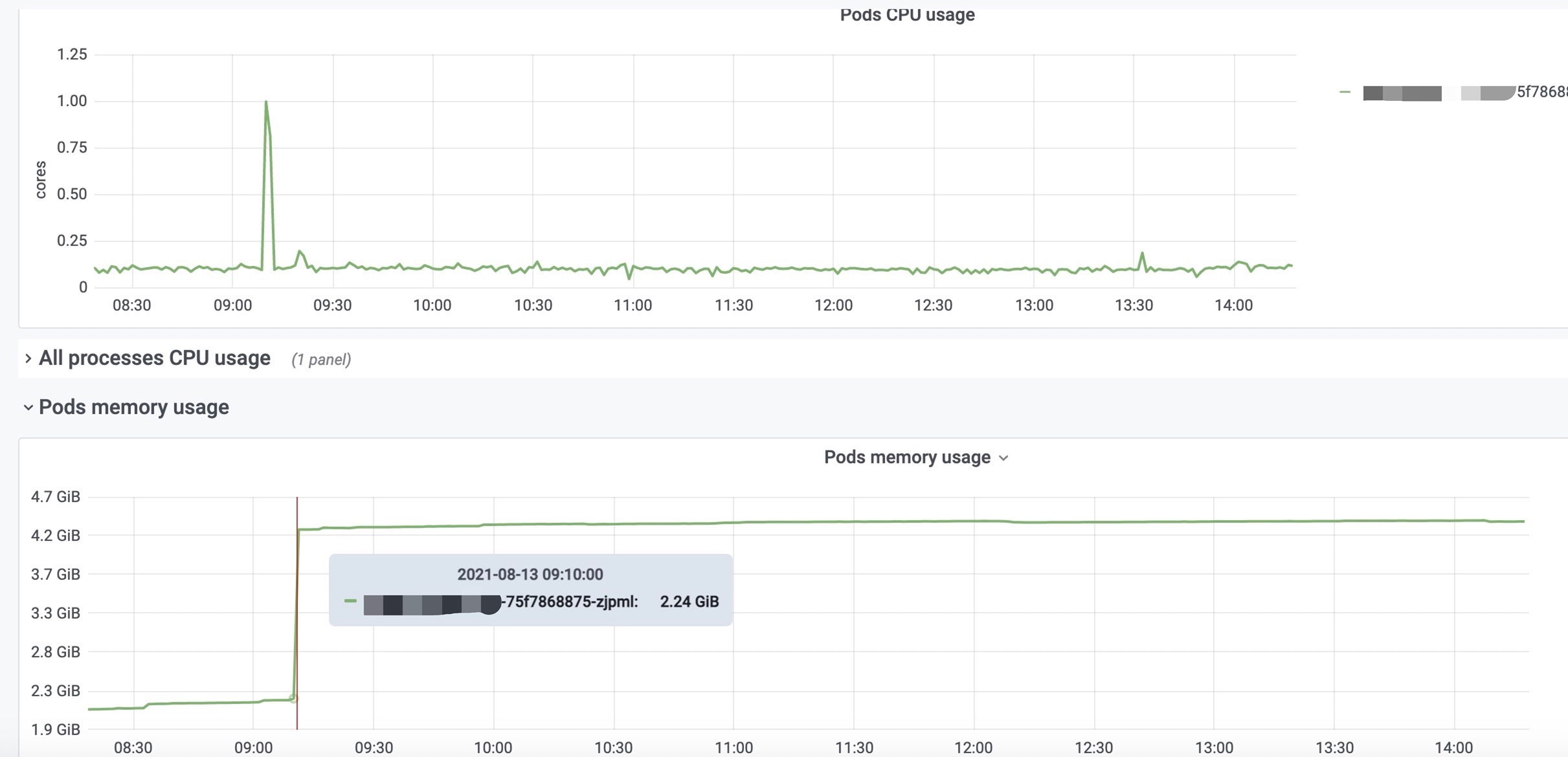

RSS内存急速增长并高于NMT内存

现象:8.13日早在无业务的情况下,内存突增2.4g左右,进入容器内查看,rss 4.3g,java nmt 内存1.8g committed,通过gdb dump pmap中不在nmt的内存,分析发现乱码,无明显业务特征

环境:跑在阿里云ACK上,java版本 openjdk version “11.0.9.1”,ARMS版本arms-bootstrap-1.7.0-SNAPSHOT.jar

相关资料

1、内存增长图

2、NMT数据nmt_online

3、gdb dump内存(pmap后找到不在nmt的内存)

gdb_online.zip

求助排查手段和解决思路

1851 阅读