GitHub Copilot代码安全性研究:开发者需对四成错原创

4年前

332900

在近日发表的一篇学术论文中,研究人员对 GitHub Copilot 人工智能编程辅助工具展开了深入调查。结果发现,仍处于测试预览阶段的 Copilot 具有高达 的错误代码率,意味着开发者必须在使用时对其保持清醒的认知。此外在多场景测试项目中,约 都被发现包含了安全漏洞。

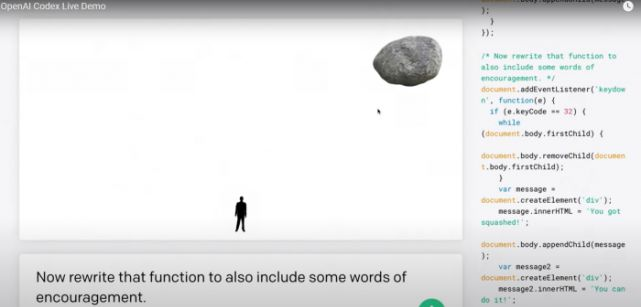

(图自:GitHub),据悉,GitHub 为这款 AI 编程辅助工具采用了来自 OpenAI 的 Codex 高级 AI 系统。特点是经过了 GPT-机器语言模型的生成式预训练,能够借助深度学习来生成类人文本。基于 GitHub 平台上高质量代码展开的训练,结合上下文和其它因素,它能够为开发者提供良好的单行代码建议、甚至帮助补全整个功能模块。

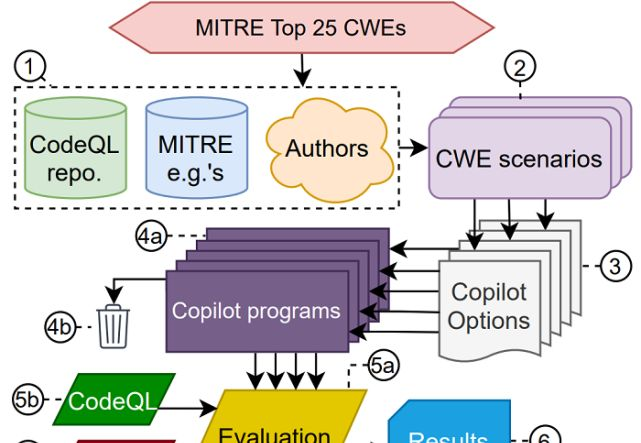

一种 Copilot 评估方法,然而 Copilot 很快引发了多方争议,尤其涉及代码质量、法律与道德考量、替换人类开发者的可能性、以及引入安全漏洞的可能性。在一项题为《GitHub Copilot 辅助编程的网络安全实证评估》的学术研究论文中,研究团队就对 Copilot 的安全性展开了重点考量。这项研究旨在描述 Copilot 生成不安全代码的趋势,为用户防范安全问题所需的审查量提供了必要的衡量标准。

点赞收藏